지난 번 Llama 3.1 설치와 터미널을 이용한 메시지 교환까지 진행해 봤습니다. 터미널로 라마 3.1과 대화하는 것은 너무 불편했죠. 때문에 오늘은 조금 더 편리한 UI로 변경하려 합니다. 가능하면 챗GPT의 Web UI 환경과 유사했으면 더 좋고요. 자, 그럼 시작할게요.

Open WebUI를 이용한 라마 3.1

지난 번에 이어진 내용이므로 라마 3.1은 이미 PC 설치됐다고 가정하고 진행합니다. 설치가 필요하다면 아래 링크로 이동하여 설치 후 본 글의 내용을 진행하시기 바랍니다.

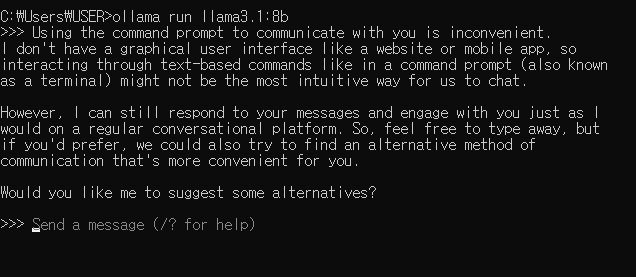

일단 라마3.1을 다시 실행해 보겠습니다. 다음과 같은 command를 명령 프롬프트에 입력하여 실행합니다.

ollama run llama3.1:8b

메시지로는 명령프롬프트로 대화하는 것은 불편하다고 말해 봅니다. 8b 버전이라 그런지 대답은 영 시원치 않습니다.

대화 내용 보다 여기에서 중요한 것은 Ollama를 통해 llama3.1을 실행하고 있다는 것입니다. 앞서 llama3.1을 설치할 때도 단순히 ollama를 통해 실행하니 자동으로 다운로드에서 설치까지 한번에 진행됐었습니다. 또, 위의 ollama 명령어로 바로 llama3.1을 실행도 시켰고요.

이는 간단하게 ollama가 llama3.1을 실행하고 있다고 봐도 문제없죠. 그러면 우리는 Web UI와 ollama를 연결하면 될 것 같습니다.

Step 1. Open WebUI 설치

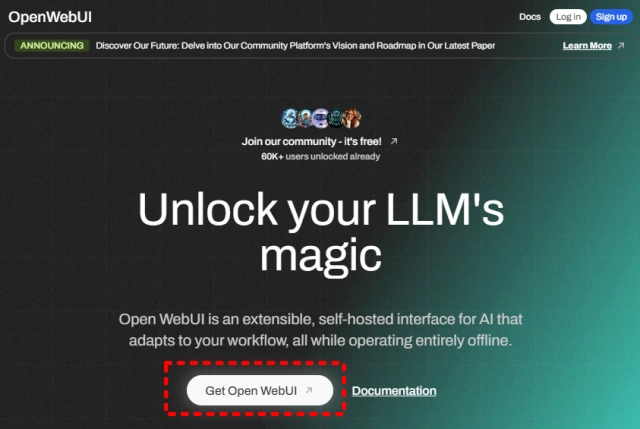

그러면, 이제 WebUI를 설치해 봅시다. Open WebUI 홈페이지로 이동합니다.

아래 그림처럼 “Get Open WebUI”를 클릭해서 github로 이동합니다.

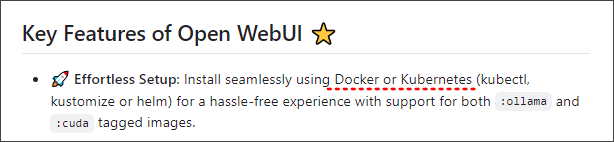

이동한 github 창을 아래로 내리면서 보면 아래와 같이 Key Features 부분이 나옵니다. Docker나 Kubernetes를 설치하는게 편리하다는 얘기 같아요.

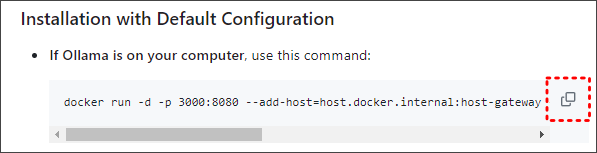

저는 Docker를 설치하겠습니다. 그냥 창을 닫지 말고 아래로 더 내려가면서 필요한 정보가 있는지 확인합니다. 아래 내려 보니 “Installation with Default Configuration” 부분에 Ollama를 PC에 설치했을 경우에 대한 command가 있네요. 아래 그림과 같이 복사를 해 둡니다. 메모장 같은 곳에 적어 둬도 좋겠네요.

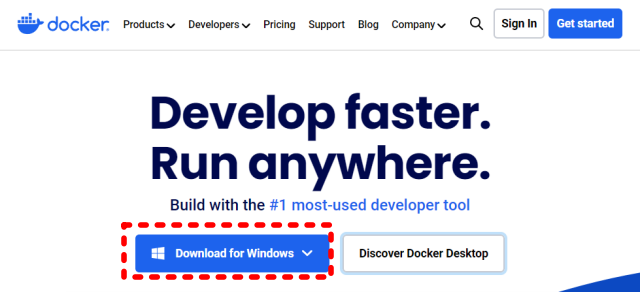

그럼 이제 Docker를 설치하기 위해 Docker 홈페이지로 이동합니다. 아래 그림과 같이 자신의 OS에 맞는지 확인 후 설치 파일을 다운로드 합니다.

다운로드 파일을 실행하여 Docker를 설치합니다. 별 다른 옵션 설정 없이 그냥 설치했습니다.

Step 2. Open WebUI 환경 설정

설치를 완료한 후 Docker를 실행합니다.

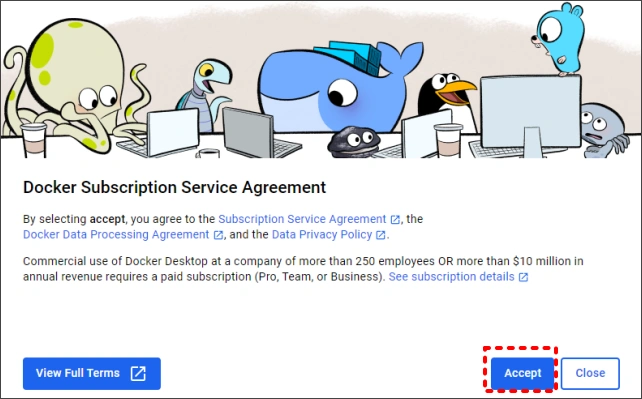

아래와 같이 가입 화면이 뜨는데, Accept하고 다음 화면으로 넘어 갑니다.

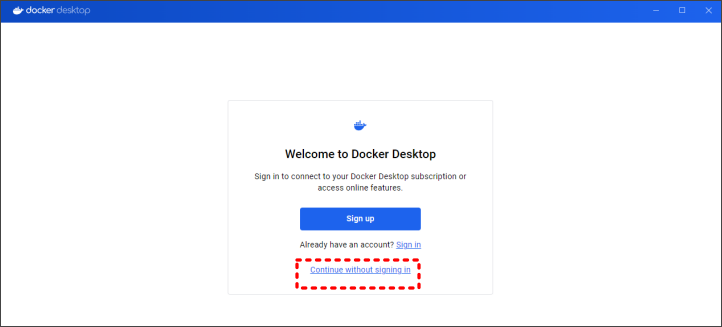

Docker 에 가입해도 좋을 거 같기는 합니다 만, 일단 그냥 아래 그림과 같이 가입 없이 진행해 봅니다.

이어져 나오는 Survey 화면도 Skip 합니다.

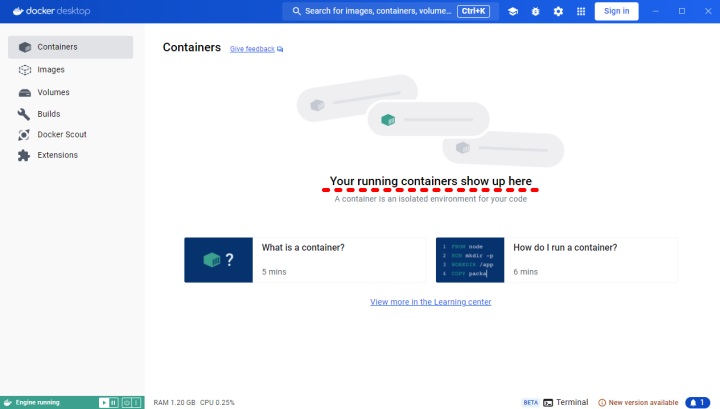

Docker 메인 화면이 나타납니다. 실행 중인 컨테이너는 아직 없으므로 “Your running containers show up here” 안내 문구만 나타납니다.

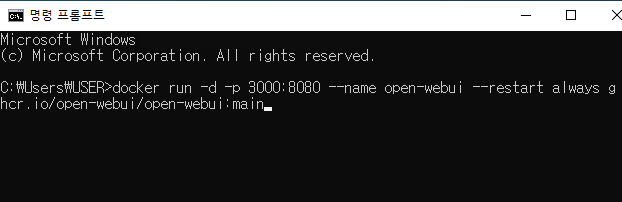

위에서 복사 두었던 command를 사용해야 할 때가 왔습니다. 명령 프롬프트를 열고 복사해 두었던 command를 입력하여 실행합니다.

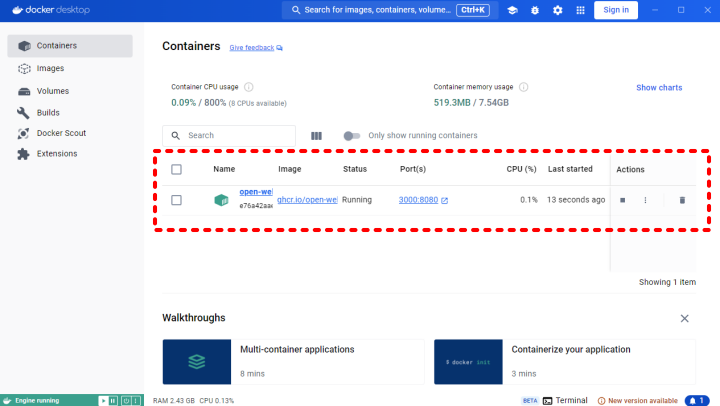

위와 같이 command를 입력하면 바로 실행 완료 됩니다. 이제 다시 Docker 화면을 열어봅니다. 앞의 “Open WebUI 환경 설정 03″과는 다르게 화면 중앙에 실행 중인 컨테이너 정보가 보입니다.

앞서 command를 그냥 복사한 후 사용만 했더니, 이와 같은 컨테이너가 실행되는 모습을 보니 이 컨테이너가 어떤 역할을 하는 것인지 생각해 볼만 한데요, 결국 Docker 프로그램은 WebUI를 포함하고 있고, Ollama와 통신할 수 있는 포트 정보를 이미 갖고 있는 것으로 생각해 볼 수 있습니다.

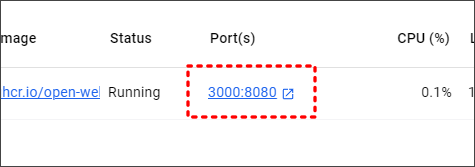

자, 그러면 위 그림처럼 화면 중앙에 보이는 “3000:8080” 위치를 클릭해서 웹 페이지를 실행해 봅니다.

Step 3. Open WebUI 실행

웹 페이지가 열리면 ID, 이메일 정보 등을 입력하는 가입 화면이 나옵니다. 이 정보는 Docker나 특정 사이트가 나가는 정보가 아니라 PC에만 기록되는 정보에요. (2024.08.02 기준)

가입을 하지 않으면 화면이 열리지 않으므로 가입해야 합니다. 요즘 브라우저에 사용자 정보를 저장해서 폰과 PC 환경을 동일하게 사용하는 경우가 많은데요, 이 화면의 가입 정보는 기기가 바뀌면 공유되지 않습니다.

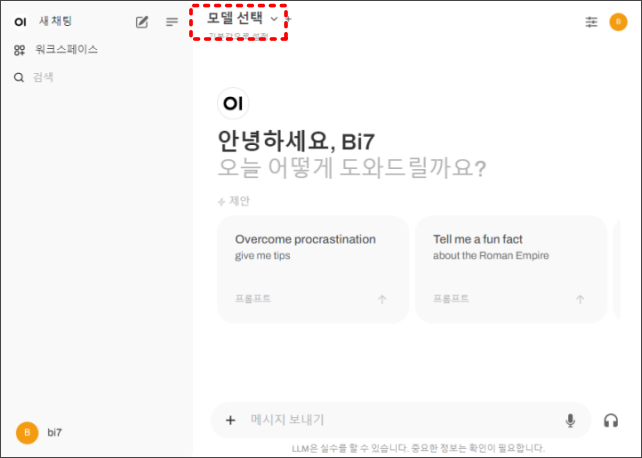

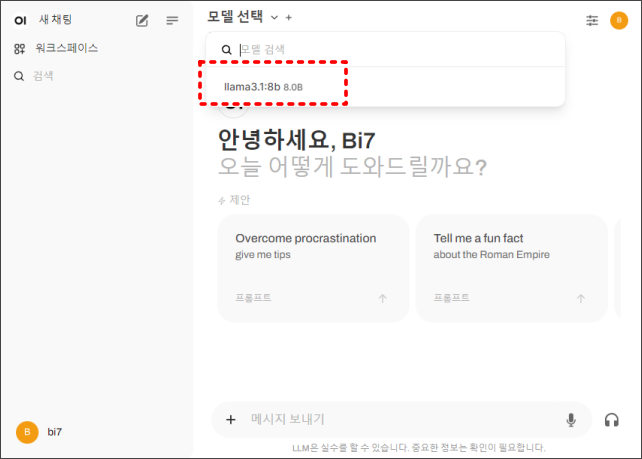

아래 그림과 같이 화면 상단의 “모델 선택”을 클릭합니다.

아래 그림과 같이 앞서 설치했던 라마 3.1 모델명이 나타납니다. 해당 모델명을 선택해 주세요.

혹시, 위와 같이 모델명이 나타나지 않는다면 Ollama 실행되고 있는지 확인해 주세요.

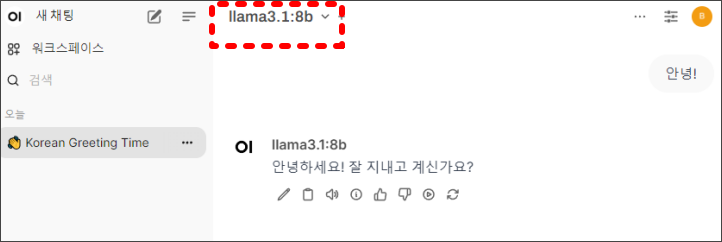

자, 이제 실제 라마 3.1과 대화가 되는지 메시지를 입력합니다. 아래 그림과 같이 간단한 입력에 응답을 합니다. 화면 좌측은 보면 “오늘”이라는 문구와 함께 챗팅 내역이 나타나는 것이 보입니다. 이 정도면 거의 챗GPT와 동일한 화면이라 할 수 있을 듯 싶습니다.

오늘은 라마 3.1의 UI를 Web UI로 변경해 보는 작업을 해 봤습니다.

관련 글도 확인해 보세요.

- Llama3.1 (Ollama)과 Python Flask로 나만의 웹UI 만들기

- Ollama로 Meta의 Llama 3.1 설치하기. AI 언어 모델 활용법

- Ollama를 통해 알아보는 최신 인공지능 언어 모델